ทุกเทคโนโลยีมีศักยภาพในการใช้งานทั้งในเชิงบวกและเชิงลบ และเป็นเรื่องจริงโดยเฉพาะอย่างยิ่งสำหรับเทคโนโลยี generative AI เช่น ChatGPT ซึ่งนับเป็นแพลตฟอร์มที่ถูกกล่าวถึงอย่างมากในแวดวง AI ซึ่ง Sam Altman ประธานเจ้าหน้าที่บริหารของ OpenAI ผู้สร้าง ChatGPT เองได้แสดงความกังวลในแถลงการณ์ฉบับล่าสุด1 โดยได้เน้นย้ำถึงความสำคัญของAI และให้นำไปใช้งานอย่างเหมาะสมและโปร่งใสพร้อมได้กล่าวเพิ่มเติมอีกว่าควรให้ความสำคัญกับเรื่อง AI ประหนึ่งการให้ความสำคัญในเรื่องความท้าทายระดับโลก อย่างเรื่องการจัดการกับโรคระบาดและสงครามนิวเคลียร์ ทั้งนี้เพื่อลดความเสี่ยงที่อาจเกิดขึ้นกับมนุษยชาติ

คุณเอกภาวิน สุขอนันต์ ผู้จัดการประจำวีเอ็มแวร์ประเทศไทย

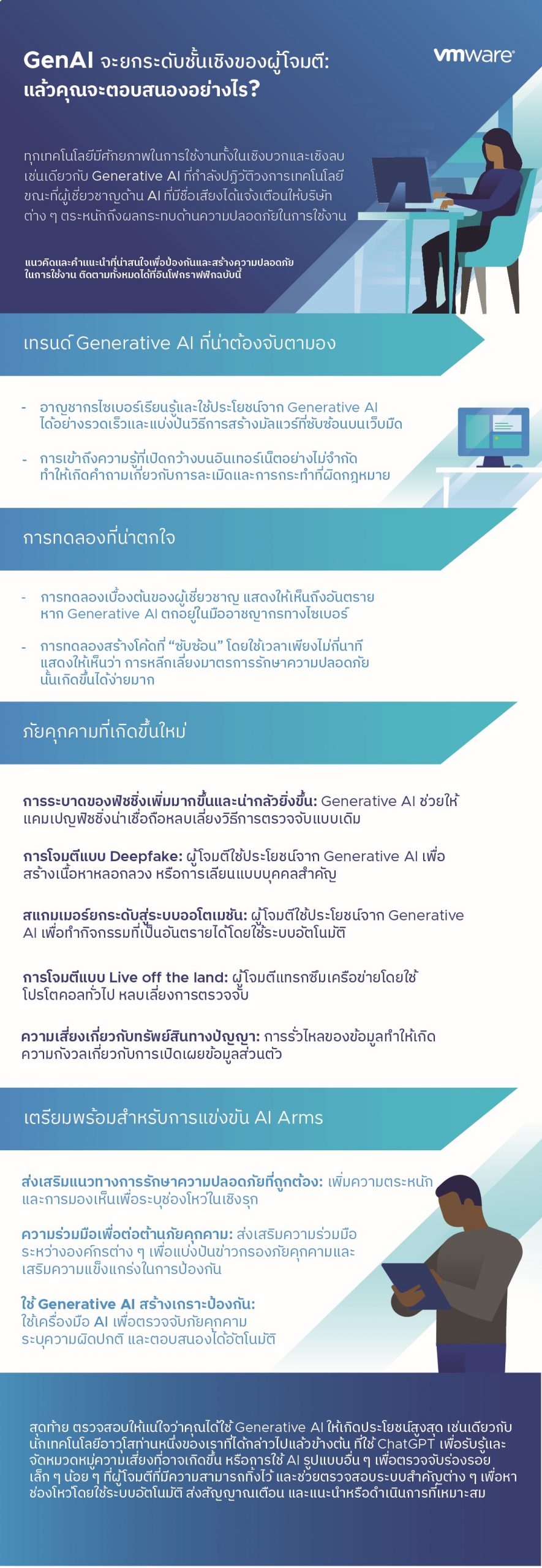

โดยความกังวลและข้อเสนอแนะข้างต้นเป็นการกระตุ้นและเน้นยำให้บริษัทต่าง ๆ พิจารณาเชิงรุกถึงผลกระทบด้านความปลอดภัยของ generative AI เป็นโอกาสสำหรับองค์กรที่จะต้องเริ่มตื่นตัวในเรื่องการปกป้องระบบและข้อมูลของตนเมื่อเผชิญกับเทคโนโลยีที่ก้าวหน้าเหล่านี้

นอกจากนี้เรายังได้พบว่า ผู้ประสงค์ร้ายอาศัยช่องทางเหล่านี้สร้างประโยชน์แก่ตนเอง ตัวอย่าง ไม่กี่สัปดาห์ หลังจากการเปิดตัว ChatGPT เมื่อเดือนพฤศจิกายนที่ผ่านมา อาชญากรไซเบอร์ได้นำเครื่องมือไปแชร์และใช้2 บนฟอรัมดาร์กเว็บ โดยเฉพาะอย่างยิ่งเครื่องมือที่สามารถใช้โดยผู้ที่ไม่มีประสบการณ์ในการเขียนโค้ด เพื่อสร้างมัลแวร์ที่ซับซ้อนขึ้นมาใหม่ สำหรับคนหลายล้านคน ChatGPT นั้นเป็นเสมือนวิศวกรคนหนึ่งที่บริษัทจ้างทำงาน –– หรือเปรียบเสมือนพนักงานที่มีศักยภาพคนหนึ่งที่เต็มไปด้วยความรู้และสามารถเข้าถึงข้อมูลบนอินเทอร์เน็ต สั่งงานได้ตลอด จัดการข้อมูลที่เราเสนอได้อย่างมหาศาลโดยไม่เสียค่าใช้จ่าย

นับเป็นอีกหนึ่งตัวอย่างที่น่ากลัว อีกหนึ่งตัวอย่างการใช้งานจริงอีกเคส คือ นักเทคโนโลยีอาวุโสท่านหนึ่งของเราขอให้ ChatGPT ช่วยค้นหาซอฟต์แวร์เพื่อเจาะไปยังช่องโหว่ด้านความปลอดภัยที่มีอยู่ และปรับเปลี่ยนเพื่อให้ไม่สามารถถูกตรวจจับหรือต้นพบได้ด้วยซอฟต์แวร์รักษาความปลอดภัยส่วนใหญ่ในปัจจุบัน เขาใช้เวลาเพียงสองนาทีกับหกคำถามเพื่อให้ได้รหัสที่ “ซับซ้อน” ที่เขาต้องการ เพื่อทดสอบขอบเขตความปลอดภัยของบริษัท เขาอาจใส่โค้ดลงบนอุปกรณ์ที่ถูกควบคุมผ่านเข้ามายังระบบรักษาความปลอดภัยของบริษัท ใช้โค้ดเพื่อในเครือข่าย จากนั้นจึงวิ่งจากที่นึง เครื่องนึง ในระบบเครือข่ายไปยังอีกเครื่องนึงไปมาอย่างอิสระภายในองค์กรเพื่อหาเป้าหมายที่แท้จริง และเข้าถึงข้อมูลที่สำคัญ อย่างไรก็ตาม นักเทคโนโลยีอาวุโสของเราในสถานการณ์นี้ได้รับอนุญาตให้ทำการทดลองโดยระบุตัวเองว่าเป็นผู้เชี่ยวชาญด้านความปลอดภัย “white hat” เท่านั้น สิ่งสำคัญคือต้องทราบว่า OpenAI ซึ่งเป็นบริษัทที่สร้างChatGPT มีวิธีป้องกันใครก็ตามที่ใช้แพลตฟอร์มอย่างโจ่งแจ้งเพื่อจุดประสงค์ที่เป็นอันตรายหรือไม่

แม้ว่าเราจะยังอยู่ในช่วงเริ่มต้นของการใช้งาน แต่ก็คาดการณ์ได้ไม่ยากถึงความเป็นไปได้ที่จะเห็นผู้ไม่หวังดีที่ใช้ประโยชน์จาก generative AI ในการสร้างความเดือดร้อน

- การระบาดของฟิชชิ่งที่เพิ่มขึ้นและน่ากลัวยิ่งขึ้น: ดังตัวอย่างข้างต้นที่แสดงให้เห็นว่า ChatGPT สามารถดำเนินการที่ซับซ้อนได้ ตัวอย่าง สามารถเขียนอีเมลฟิชชิ่งได้ง่ายพอ ๆ กับเขียนเพลงหรือภาคนิพนธ์ (term paper) และสามารถสร้างเนื้อหาได้อย่างน่าเชื่อถือ3 มากกว่าผู้โจมตีจำนวนมาก กี่ครั้งแล้วที่คุณถูกล่อลวงให้คลิกอีเมล จนกระทั่งสังเกตเห็นการสะกดผิดหรือข้อผิดพลาดทางไวยากรณ์ที่ทำให้เห็นได้ชัดว่าผู้เขียนเขียนได้ไม่ดี แต่แล้ว ข้อผิดพลาดเหล่านั้นจะหายไปโดยอัตโนมัติโดย ChatGPT

- การโจมตีแบบ Deepfake: ผู้โจมตีอาจสร้างโน้ตที่ดูเหมือนว่ามาจาก CEO ของคุณหรืออาจสร้างข้อความที่คล้ายมากจนคุณแยกไม่ออก เช่นเดียวกับที่คุณสามารถขอให้ ChatGPT เขียนบทกวีในสไตล์ของ Henry David Thoreau อีกหนึ่งตัวอย่างคือ บริษัทญี่ปุ่นตกเป็นเหยื่อของการโจมตีด้วย Deepfake Audio ในปี 2021 เมื่อผู้จัดการสาขาถูกหลอกให้โอนเงิน 35 ล้านดอลลาร์4 ไปยังบัญชีปลอม หลังจากได้รับโทรศัพท์จากบุคคลที่ฟังดูเหมือนเจ้าหน้าที่ระดับสูงของบริษัท

- ระบบออโตเมชัน: การโจมตีทางไซเบอร์ที่มีประสิทธิภาพจำเป็นต้องทำงานที่น่าเบื่อมากมาย ซึ่งส่วนใหญ่เหมาะสำหรับ generative AI ดังนั้น ผู้ใช้ทั้งที่ประสงค์ดีและประสงค์ร้ายจึงกำลังตรวจสอบวิธีการใช้ generative AI เพื่อทำให้งานเป็นไปโดยอัตโนมัติ ปัจจุบัน นักพัฒนาจำนวนมากใช้เครื่องมือ generative AI เช่น GitHub Copilot เพื่อจัดการงานการเขียนโปรแกรมระดับทั่วไปต่างๆ และแปลโค้ด5 เป็นภาษาอื่นสำหรับการปรับใช้ข้ามแพลตฟอร์ม ดังที่ Giovanni Vigna, Sr. Director Threat Intelligence ของ VMware กล่าวเทคนิคดังกล่าวอาจถูกใช้โดยการดำเนินการบิดเบือนข้อมูลอย่างมืออาชีพแทนการจ้างผู้เขียนเพื่อโพสต์หลอกลวง

- การโจมตีแบบ Live off the land: ในช่วงไม่กี่ปีที่ผ่านมา เป้าหมายของการโจมตีคือการเจาะเข้าไปในเครือข่ายและหลบเลี่ยงการตรวจจับเนื่องจากพวกเขามองหาเป้าหมายที่มีค่า ตามปกติแล้ว การโจมตีจะใช้โปรโตคอลเดียวกันกับที่ผู้ดูแลระบบเครือข่ายใช้ในการทำงาน เช่น Remote Desktop Protocol (RDP) ที่พวกเขาใช้เพื่อแก้ไขปัญหาของผู้ใช้มักถูกใช้ในการโจมตีซึ่งนับเป็นหนึ่งใน “พฤติกรรมเครือข่ายที่สังเกตบ่อยที่สุดที่เกี่ยวข้องกับการเคลื่อนไหวจากเครื่องนึงไปยังอีกเครื่องนึงไปเรื่อยแบบ lateral จนกว่าจะเจอเป้าหมายที่แท้จริง”6

- ความกังวลเรื่องความเป็นส่วนตัวเกี่ยวกับทรัพย์สินทางปัญญา: ChatGPT เชื่อมโยงกับการรั่วไหลของข้อมูลที่ถูกกล่าวหา โดยพนักงานแชร์ข้อมูลลับขององค์กรกับ ChatGPT ซึ่งเป็นการเปิดข้อมูลให้กับผู้ใช้ OpenAI แหล่งที่มา7 ระบุว่าสิ่งนี้ “รวมถึงซอร์สโค้ดของซอฟต์แวร์ที่รับผิดชอบในการวัดอุปกรณ์เซมิคอนดักเตอร์”

แล้วบริษัทต่าง ๆ จะทำอะไรได้บ้างเพื่อเตรียมพร้อมสำหรับการโจมตีที่เสริมประสิทธิภาพด้วย AI สำหรับผู้เริ่มต้น พวกเขาจำเป็นต้องมีระบบการรักษาความปลอดภัยที่ดี ในการสำรวจเมื่อเร็วๆ นี้ “71 เปอร์เซ็นต์ของผู้ตอบแบบสอบถามกล่าวว่าการโจมตีเปิดเผยช่องโหว่ที่พวกเขาไม่รู้ตัวด้วยซ้ำว่ามี ดังนั้นการมองเห็นและการรับรู้ถือเป็นเรื่องพื้นฐานสำหรับการรักษาความปลอดภัยที่ดี8 แม้ว่าคุณจะหลีกเลี่ยงการโจมตีมาได้หลายต่อหลายครั้งแล้วก็ตาม แต่เมื่อ generative AI มีมากขึ้น โอกาสในการตกเป็นเป้าหมายของคุณก็จะเพิ่มขึ้น

นอกจากนี้ ในองค์กรควรจะพูดคุยอย่างเปิดเผยในเรื่องภัยคุกคามต่างๆต่อกันและกันมากขึ้น เพื่อให้สามารถรวบรวมความรู้ร่วมกันและป้องกันการโจมตีครั้งใหม่ได้ ผู้เชี่ยวชาญด้านความปลอดภัยทางไซเบอร์ของคุณจะพร้อมมากขึ้นหากองค์กรและภาคส่วนต่าง ๆ แบ่งปันข่าวกรองภัยคุกคาม

สุดท้าย ตรวจสอบให้แน่ใจว่าคุณได้ใช้ generative AI ให้เกิดประโยชน์สูงสุด เช่นเดียวกับนักเทคโนโลยีอาวุโสท่านหนึ่งของเราที่ได้กล่าวไปแล้วข้างต้น ที่ใช้ ChatGPT เพื่อรับรู้และจัดหมวดหมู่ความเสี่ยงที่อาจเกิดขึ้น นอกจากนี้ เราสามารถใช้ AI รูปแบบอื่น ๆ เพื่อตรวจจับร่องรอยเล็กน้อยที่ผู้โจมตีที่มีความสามารถทิ้งไว้ และช่วยตรวจสอบระบบสำคัญต่าง ๆ เพื่อหาช่องโหว่โดยอัตโนมัติ ส่งสัญญาณเตือน และดำเนินการที่เหมาะสม

[1] New York Times, “A.I. Poses ‘Risk of Extinction,’ Industry Leaders Warn,” by Kevin Roose, May 2023.

[2] SC Magazine, “Cybercriminals are already using ChatGPT to own you,” by Derek B. Johnson, January 2023.

[3] WIRED. “Brace Yourself for a Tidal Wave of ChatGPT Email Scams,” Bruce Schneier and Barath Raghavan, April 2023.

[4] Dark Reading, “Deepfake Audio Scores $35M in Corporate Heist,” Robert Lemos, October 2021.

[5] SC Media, “Cybercriminals are already using ChatGPT to own you,” Derek B. Johnson, January 2023.

[6] VMware Security Blogs, “Lateral Movement in the Real World: A Quantitative Analysis,” Stefano Ortolani and Giovanni Vigna, June 2022. Note: see Figure 6.

[7] VMware. “Global Incident Response Threat Report,” August 2022. Note: see page 10 for 71% metric.

[8] Cybernews, “ChatGPT tied to Samsung’s alleged data leak,” Villius Petkauskas, April 2023.